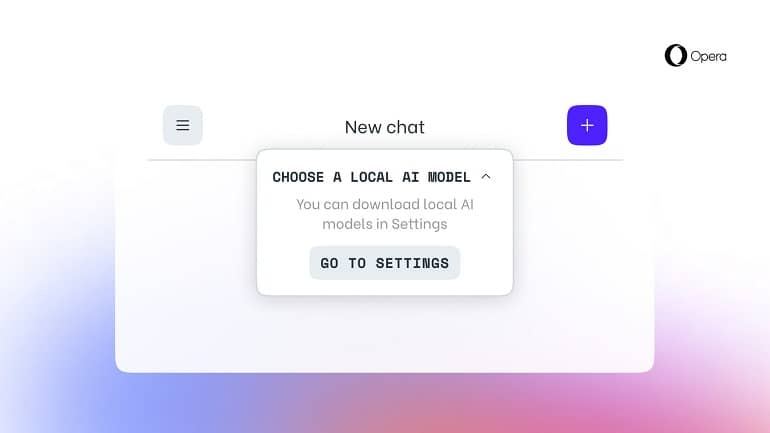

اپرا اکنون به کاربران اجازه می دهد تا LLMها را به صورت لوکال اجرا کنند

اپرا ویژگی جدیدی را معرفی کرده که به کاربران امکان می دهد مدل های زبان بزرگ (LLM) را به صورت لوکال در رایانه خود دانلود و استفاده کنند. این ویژگی برای کاربران Opera One که بهروزرسانیهای استریم توسعهدهنده را دریافت میکنند در دسترس است. با آن، کاربران می توانند به بیش از 150 مدل از بیش از 50 خانواده، از جمله Llama از متا، Gemma از گوگل، Vicuna، Mistral AI و غیره دسترسی داشته باشند.

اپرا این ویژگیهای جدید را به عنوان بخشی از “برنامه دراپ ویژگی هوش مصنوعی” خود میخواند و وعده داده که دادههای کاربر به صورت لوکال در دستگاه آنها نگهداری میشود و به آنها اجازه میدهد بدون نیاز به ارسال اطلاعات به سرور از هوش مصنوعی مولد استفاده کنند. این شرکت از چارچوب متن باز Ollama برای اجرای این مدل ها بر روی رایانه های کاربران استفاده می کند. هر نوع از مدل ها بین 2 تا 10 گیگابایت فضای روی سیستم نیاز دارد.

اپرا سخت تلاش می کند تا با این ویژگی های جدید از هوش مصنوعی استفاده کند، اگرچه LLM های محلی اولین چیزی نیستند که مرورگر دارای هوش مصنوعی است. با راه اندازی Opera One در سال گذشته، این شرکت به وضوح نشان داد که تلاش می کند یک مرورگر پرچمدار مبتنی بر هوش مصنوعی باشد و حتی آریا، دستیار هوش مصنوعی خود را راه اندازی کرد. این ویژگی ها به Opera کمک می کند تا با ارائه ویژگی های منحصر به فرد و نوآورانه به کاربران خود، سهم بازار خود را افزایش دهد. طبق آمار Statcounter، از مارس 2024، اپرا سهم بازار مرورگرهای دسکتاپ 3.15 درصد را دارد.